Beim Eintauchen in die Welt des Web-Scrapings ist es entscheidend, die Nuancen zwischen Scrapy und Selenium zu verstehen.

Diese beiden Frameworks stechen als robuste Werkzeuge in der Web-Scraping-Toolbox hervor, jedes mit seinen einzigartigen Stärken und Anwendungen.

Um sich in dieser Landschaft effektiv zu bewegen, ist es wichtig, das Wesen von Selenium und Scrapy zu erfassen und die Schlüsselunterschiede zu erkennen, die sie voneinander abgrenzen.

Lasst uns eine Reise beginnen, um diese leistungsstarken Technologien zu erforschen und Licht darauf zu werfen, wann man Selenium wählen sollte, wann man Scrapy einsetzen sollte und wie die Wahl zwischen ihnen Ihre Web-Scraping-Bemühungen erheblich beeinflussen kann.

Selenium

Selenium ist ein leistungsfähiges Web-Testing-Framework, das ursprünglich für die Automatisierung von Browserinteraktionen im Bereich des Software-Tests entwickelt wurde. Seine Vielseitigkeit geht jedoch über das Testen hinaus und macht es auch zu einem wertvollen Werkzeug für das Web-Scraping.

Was ist Selenium?

Selenium ist ein Open-Source-Framework, das eine Suite von Werkzeugen für die Automatisierung von Webbrowsern bietet. Es unterstützt mehrere Programmiersprachen, einschließlich Python, Java und C#, was es für eine breite Palette von Entwicklern zugänglich macht. Selenium WebDriver, eine Schlüsselkomponente, ermöglicht es Benutzern, Browseraktionen programmgesteuert zu steuern, was Aufgaben wie das Ausfüllen von Formularen, das Klicken auf Schaltflächen und das Navigieren durch Webseiten ermöglicht.

Umgang mit dynamischem Inhalt: Selenium ist hervorragend geeignet für den Umgang mit dynamischem Inhalt, der durch JavaScript generiert wird. Seine Fähigkeit, in Echtzeit mit dem DOM (Document Object Model) zu interagieren, macht es geeignet für das Scrapen von Daten von modernen, interaktiven Websites.

Breite Browser-Unterstützung: Selenium unterstützt verschiedene Browser, einschließlich Chrome, Firefox, Safari und Edge. Diese Flexibilität ermöglicht es Entwicklern, den Browser zu wählen, der am besten zu ihren Scraping-Bedürfnissen passt.

Benutzersimulation: Selenium kann das Verhalten von Benutzern emulieren, durch Seiten navigieren und mit Elementen interagieren, genau wie ein menschlicher Benutzer. Das ist vorteilhaft für Scraping-Szenarien, bei denen Benutzerinteraktionen notwendig sind.

Ressourcenintensiv: Selenium arbeitet, indem es einen vollständigen Browser startet, was ressourcenintensiv sein kann. Dies macht es im Vergleich zu leichtgewichtigeren Scraping-Alternativen langsamer, insbesondere beim Umgang mit einer großen Anzahl von Anfragen.

Steile Lernkurve: Aufgrund seiner umfangreichen Fähigkeiten könnte das Erlernen von Selenium für Anfänger eine steilere Lernkurve erfordern. Das Verständnis der Feinheiten der Browserautomatisierung und der DOM-Manipulation kann eine Herausforderung sein.

Erkennungsherausforderungen: Websites sind mittlerweile geschickt darin geworden, automatisierte Bot-Aktivitäten zu erkennen, und Selenium ist davor nicht gefeit. Einige Websites setzen Maßnahmen ein, um Selenium-getriebene Scraper zu identifizieren und zu blockieren, was zusätzliche Anstrengungen erfordert, um Erkennungsmechanismen zu umgehen.

Scrapy

Scrapy steht als ein hochrangiges, Open-Source Web-Crawling und Web-Scraping-Framework für Python. Im Gegensatz zu Selenium, das sich auf die Browserautomatisierung konzentriert, ist Scrapy speziell für das effiziente Extrahieren von Daten von Websites konzipiert, basierend auf den Prinzipien von Spiders und Pipelines.

Was ist Scrapy?

Scrapy ist ein Python-Framework, das für Web-Crawling und -Scraping-Aufgaben entwickelt wurde. Es bietet eine strukturierte Methode, um zu definieren, wie man Websites navigiert, welche Elemente extrahiert werden sollen und wie die gescrapten Daten gespeichert werden. Das Framework verwendet eine modulare Architektur und setzt Spiders ein, um die Crawling-Logik zu definieren, und Pipelines, um die extrahierten Informationen zu verarbeiten und zu speichern.

Effizienz und Geschwindigkeit: Scrapy ist bekannt für seine Effizienz und Geschwindigkeit. Es arbeitet asynchron, was die gleichzeitige Ausführung mehrerer Anfragen ermöglicht. Dies macht es besonders effektiv für großangelegte Scraping-Aufgaben, bei denen Geschwindigkeit wesentlich ist.

Strukturierte Datenextraktion: Scrapy vereinfacht den Prozess der Datenextraktion durch seine integrierten Mechanismen. Selektoren und Item Pipelines helfen dabei, Daten zu organisieren und zu verarbeiten, und bieten einen strukturierten Ansatz für das Scraping.

Erweiterbarkeit: Scrapy ist hochgradig erweiterbar und anpassbar. Entwickler können seine Funktionalität an spezifische Scraping-Anforderungen anpassen und erweitern, was es zu einer vielseitigen Wahl für diverse Web-Scraping-Projekte macht.

JavaScript-Rendering: Scrapy kann Schwierigkeiten haben, mit Websites umzugehen, die stark auf JavaScript für das Content-Rendering angewiesen sind. Obwohl es einige JavaScript-basierte Interaktivität bewältigen kann, könnte es in Szenarien, in denen dynamischer Inhalt Browser-Interaktion erfordert, zu kurz kommen.

Lernkurve: Für Neulinge im Web-Scraping könnte Scrapy eine Lernkurve darstellen. Das Verständnis seiner Architektur, insbesondere der Konzepte von Spiders und Pipelines, kann für diejenigen, die mit dem Framework nicht vertraut sind, Zeit in Anspruch nehmen.

Eingeschränkte Browser-Interaktion: Scrapy bietet nicht das gleiche Maß an Browser-Interaktion wie Selenium. Wenn eine Scraping-Aufgabe die Simulation von Benutzerverhalten auf dynamischen Websites erfordert, ist Scrapy möglicherweise nicht die geeignetste Wahl.

Scrapy vs Selenium: Ein detaillierter Vergleich

Beim Eintauchen in die Welt des Web-Scrapings kann die Wahl zwischen Scrapy und Selenium einen erheblichen Einfluss auf den Erfolg Ihrer Datenextraktionsbemühungen haben. Jedes Framework bringt seine einzigartigen Stärken mit sich, und das Verständnis der Nuancen zwischen ihnen ist entscheidend, um eine fundierte Entscheidung zu treffen.

Scraping mit Selenium vs Scraping mit Scrapy

| Merkmal | Selenium | Scrapy |

|---|---|---|

| Automation | Webbrowser-Automatisierung | Spezialisiertes Web-Scraping-Framework |

| Interaktion | Simuliert Benutzeraktionen | Strukturierter Ansatz mit Spiders und Pipelines |

| JavaScript | Handhabt dynamisch durch JavaScript gerenderten Inhalt | Effizient für großangelegte Scraping-Aufgaben |

| Eignung | Hochinteraktive Websites | Großangelegtes Scraping |

| Stärken | Flexibilität, Fähigkeit, komplexe Interaktionen zu handhaben | Effizienz, Skalierbarkeit |

| Schwächen | Langsamer als Scrapy | Erfordert mehr Konfiguration |

| Gesamt | Ein leistungsstarkes Werkzeug für dynamische Scraping-Aufgaben | Eine effiziente Wahl für großangelegte Scraping-Projekte |

Seitliche Vergleich: Scrapy vs. Selenium

- Anwendungsfälle

- Selenium ist ideal für Szenarien, in denen Browserinteraktion und JavaScript-Ausführung kritisch sind, was es für dynamische und interaktive Websites geeignet macht.

- Scrapy, mit seinem Fokus auf Effizienz und strukturierter Datengewinnung, eignet sich besser für großangelegte Scraping-Projekte, bei denen Geschwindigkeit und Organisation entscheidend sind.

- Geschwindigkeit und Effizienz

- Scrapys asynchrone Arbeitsweise ermöglicht schnelleres Scraping, insbesondere bei einer großen Anzahl von Anfragen.

- Selenium, obwohl leistungsfähig, kann ressourcenintensiv und langsamer sein aufgrund seines Ansatzes zur Browserautomatisierung.

- Lernkurve

- Selenium kann eine steilere Lernkurve haben, insbesondere für Neulinge im Web-Scraping. Seine umfangreichen Fähigkeiten und Browserautomatisierungskonzepte erfordern ein tieferes Verständnis.

- Scrapy, obwohl nicht ohne Komplexität, könnte für Anfänger zugänglicher sein.

- JavaScript-Handling

- Selenium glänzt im Umgang mit JavaScript-basiertem Content-Rendering, während Scrapy Herausforderungen in Szenarien begegnen kann, in denen umfangreiche JavaScript-Interaktionen erforderlich sind.

Bei der Wahl zwischen Scrapy und Selenium spielen die Art der Scraping-Aufgabe, das Ausmaß an Interaktivität auf den Ziel-Websites und die Präferenz für Geschwindigkeit und Effizienz alle eine entscheidende Rolle. Es ist eine Entscheidung, die von den spezifischen Anforderungen des jeweiligen Projekts abhängt.

Können Scrapy und Selenium Zusammen Genutzt Werden? Ein kollaborativer Ansatz

In bestimmten Web-Scraping-Szenarien kann die Kombination der Stärken von Scrapy und Selenium eine leistungsstarke und flexible Lösung bieten.

Während Scrapy geschickt darin ist, effizient zu navigieren und strukturierte Daten zu extrahieren, kann Selenums Stärke im Umgang mit dynamischem und JavaScript-intensivem Inhalt Scrapy ergänzen.

Dieser kollaborative Ansatz ermöglicht eine umfassendere Scraping-Strategie, die eine breitere Palette von Herausforderungen bewältigt.

Wie man die Scrapy-Selenium-Kombination implementiert

Die Integration von Scrapy mit Selenium umfasst die Nutzung der Stärken beider Frameworks, um eine einheitliche Scraping-Lösung zu schaffen. Ein gängiger Ansatz ist die Verwendung von Selenium innerhalb von Scrapy's Spider, um spezifische Seiten oder Elemente zu handhaben, die eine dynamische Interaktion erfordern. Dies kann durch die Nutzung des Selenium WebDriver in Verbindung mit Scrapy's Spiders erreicht werden.

- Ziel-Seiten Identifizieren: Bestimmen Sie, welche Seiten oder Elemente innerhalb einer Website die Verwendung von Selenium für effektives Scraping benötigen. Dies sind typischerweise Seiten mit dynamischem Inhalt oder starker Abhängigkeit von JavaScript.

- Selenium in Scrapy Spider Integrieren: Implementieren Sie innerhalb des Scrapy-Spiders Selenium, um die identifizierten Seiten zu navigieren und zu interagieren. Verwenden Sie den Selenium WebDriver, um Benutzeraktionen zu simulieren, wie das Klicken auf Schaltflächen oder die Handhabung dynamischer Elemente.

- Kombination von Datenextraktionsmethoden: Scrapy's strukturierte Datenextraktionsmechanismen, wie Item Pipelines und Selektoren, können weiterhin für den Großteil des Scraping-Prozesses eingesetzt werden. Selenium kommt selektiv für spezifische Interaktionen zum Einsatz, in denen es sich auszeichnet.

- Asynchrone Operationen Handhaben: Da Scrapy asynchron arbeitet, stellen Sie sicher, dass die Integration mit Selenium die Gesamteffizienz nicht beeinträchtigt. Verwalten Sie asynchrone Operationen ordnungsgemäß, um die Geschwindigkeit und Skalierbarkeit, die Scrapy bietet, auf rechtzuerhalten.

- Optimierung für Leistung: Feinabstimmung der Kombination zur Optimierung der Leistung. Dies kann das Anpassen der Häufigkeit von Selenium-getriebenen Interaktionen und die Nutzung von Scrapys Fähigkeiten für parallele Verarbeitung beinhalten.

Durch die strategische Kombination von Scrapy und Selenium können Entwickler die Stärken beider Frameworks nutzen und so eine vielseitige und effiziente Web-Scraping-Lösung schaffen.

Dieser kollaborative Ansatz ist besonders wertvoll, wenn es um den Umgang mit komplexen Websites geht, die eine nuancierte Scraping-Strategie erfordern.

Verständnis Spezifischer Anwendungsfälle für Beide Werkzeuge

Im Bereich des Web-Scrapings hängt die Wahl zwischen Scrapy und Selenium von den spezifischen Eigenschaften der Zielwebsites und der Natur der Scraping-Aufgabe ab. Jedes Werkzeug bringt seine einzigartigen Stärken mit, und das Verständnis der idealen Anwendungsfälle für beide, Scrapy und Selenium, ist wesentlich, um fundierte Entscheidungen zu treffen.

Für Dynamischen Inhalt - Wählen Sie Selenium

Selenium erweist sich als bevorzugte Wahl, wenn es um dynamische Webseiten geht. Websites, die stark von JavaScript für das Laden und Rendern von Inhalten abhängen, werden am besten mit Selenium navigiert. Seine Fähigkeit, echte Benutzerinteraktionen wie Klicks und Formulareingaben zu simulieren, gewährleistet ein genaues Scraping von dynamisch generiertem Inhalt.

Für Statischen Inhalt - Wählen Sie Scrapy

Wenn die Zielwebsite hauptsächlich statische Inhalte ohne komplexe JavaScript-Elemente bietet, sticht Scrapy als die effizientere Lösung hervor. Scrapy ist ausgezeichnet im Navigieren und Extrahieren von Daten aus statischen Webseiten und bietet einen schnelleren Prozess im Vergleich zu Selenium in solchen Szenarien.

Für Interaktive Websites - Betrachten Sie Selenium

Websites, die Benutzerinteraktion erfordern, wie solche mit komplexen Formularen oder mehrstufigen Prozessen, verlangen nach den interaktiven Fähigkeiten von Selenium. Seine Kapazität, Browseraktionen auf eine Weise zu automatisieren, die menschliches Verhalten nachahmt, macht es zur ersten Wahl für das Scraping von Daten von interaktiven Seiten.

Für Großangelegtes Dynamisches Scraping - Betrachten Sie Scrapy mit Splash

In Situationen, in denen großangelegtes dynamisches Scraping unerlässlich ist, erweist sich eine Kombination aus Scrapy und Splash als eine mächtige Lösung. Splash ist ein headless Browser, der sich nahtlos in Scrapy integrieren lässt und ein effizientes Handling von JavaScript-intensiven Websites ermöglicht. Diese Kombination ermöglicht die Skalierbarkeit, die für das Scrapen großer Mengen dynamischer Daten mit Präzision und Geschwindigkeit erforderlich ist.

Alternativen zu Selenium und Scrapy

Da sich die Landschaft der Web-Scraping-Tools weiterentwickelt, bieten Alternativen zu Selenium und Scrapy zusätzliche Optionen für Entwickler, die spezialisierte Lösungen suchen. Während Selenium und Scrapy sich als robuste Optionen etabliert haben, bieten die folgenden Tools alternative Ansätze, um spezifische Scraping-Anforderungen zu adressieren.

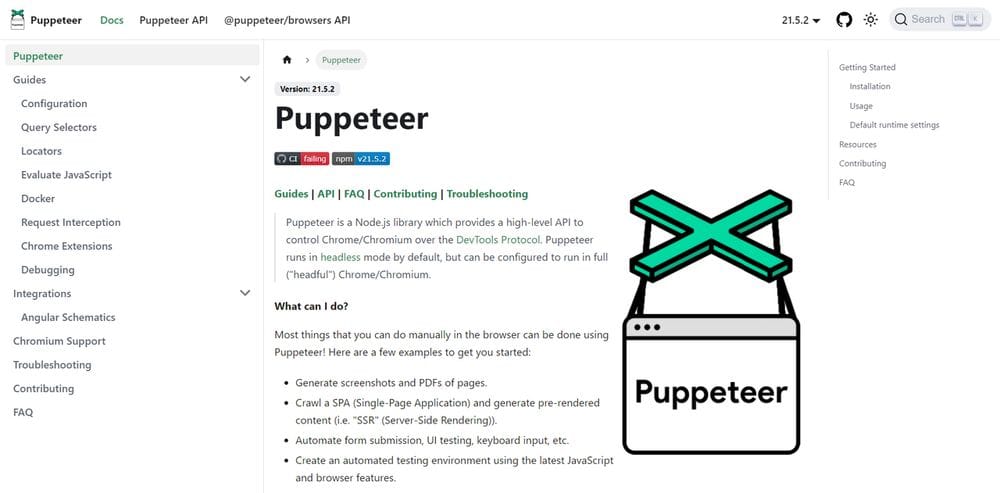

1. Puppeteer

Puppeteer, entwickelt von Google, ist eine Node.js-Bibliothek, die eine High-Level-API zur Steuerung von headless Browsern oder vollständigen Browsern bietet.

Es glänzt in Szenarien, in denen Browserautomatisierung und Rendering entscheidend sind. Mit seinem Fokus auf Chrome ist Puppeteer geschickt im Umgang mit JavaScript-lastigen Websites und eignet sich besonders für Aufgaben, die browserbasierte Interaktion erfordern.

2.Beautiful Soup

Beautiful Soup ist eine Python-Bibliothek, die für das Extrahieren von Daten aus HTML- und XML-Dateien konzipiert ist.

Während es die Browserautomatisierungsfähigkeiten von Selenium fehlen, glänzt es in Szenarien, in denen es darum geht, statische HTML-Inhalte zu parsen und zu extrahieren. Gepaart mit einer Bibliothek wie Requests für HTTP-Anfragen bietet Beautiful Soup eine leichte Alternative für einfache Scraping-Aufgaben.

3. Pyppeteer

Inspiriert von Puppeteer, ist Pyppeteer eine Python-Bibliothek, die eine pythonische Schnittstelle zu Puppeteer bietet.

Es ermöglicht Browserautomatisierung und JavaScript-Rendering ähnlich wie Puppeteer, jedoch in einer Python-Umgebung. Pyppeteer ist eine geeignete Alternative für Entwickler, die Puppeteers Fähigkeiten schätzen, aber in Python arbeiten möchten.

4. Apache Nutch

Apache Nutch ist ein Open-Source-Web-Crawling-Framework basierend auf Java.

Es bietet eine skalierbare und erweiterbare Lösung für Web-Scraping, insbesondere im Kontext des Aufbaus von Suchmaschinen oder großangelegten Webcrawlern. Die modulare Architektur von Apache Nutch ermöglicht es Entwicklern, seine Funktionalität basierend auf Projektanforderungen anzupassen und zu erweitern.

Das Erkunden von Alternativen zu Selenium und Scrapy bietet Entwicklern ein vielfältiges Toolkit, sodass sie Werkzeuge wählen können, die besser auf die spezifischen Bedürfnisse ihrer Scraping-Projekte abgestimmt sind. Jede Alternative bringt ihre eigenen Stärken und Kompromisse mit sich und bietet Flexibilität und Anpassungsfähigkeit im sich ständig weiterentwickelnden Feld des Web-Scrapings.

Fazit

In der dynamischen Landschaft des Web-Scrapings ist die Wahl zwischen Scrapy und Selenium nuanciert und abhängig von den spezifischen Anforderungen der Scraping-Aufgabe. Selenums Stärke in der Browserautomatisierung und dem Handling von dynamischen Inhalten macht es unverzichtbar für Szenarien, in denen Benutzerinteraktion und JavaScript-Ausführung kritisch sind. Umgekehrt glänzt Scrapy in der Effizienz beim Web-Crawling und strukturierter Datengewinnung in Situationen, in denen ein strukturierter Ansatz und Skalierbarkeit von höchster Bedeutung sind.

Die Entscheidung zwischen Scrapy und Selenium ist nicht universell; sie hängt von Faktoren wie der Art der Zielwebsites und dem erforderlichen Interaktionsgrad ab. Für dynamische und interaktive Sites sticht Selenium hervor, während Scrapy im Umgang mit statischen Inhalten und großangelegten Scraping-Unternehmungen glänzt.

Wenn Entwickler die Landschaft des Web-Scrapings navigieren, fügt die Berücksichtigung alternativer Tools wie Puppeteer, Beautiful Soup, Pyppeteer und Apache Nutch weitere Dimensionen zu ihrem Toolkit hinzu. Jedes Tool bringt einzigartige Funktionen und Kompromisse mit sich und ermöglicht es Entwicklern, ihre Wahl auf die spezifischen Anforderungen des Projekts zuzuschneiden.

Letztendlich liegt der Erfolg im Web-Scraping in einer durchdachten Auswahl von Tools, die mit den Zielen des Projekts abgestimmt sind. Ob man sich für Scrapy, Selenium oder Alternativen entscheidet, ein strategischer Ansatz gewährleistet eine effiziente und effektive Datengewinnung aus den vielfältigen Webumgebungen, denen Entwickler begegnen.

Für die weitere Lektüre könnte Sie Folgendes interessieren: